Robots.txt es un archivo de texto plano (robots.txt) que los administradores de páginas web crean para mostrar a los robots web (generalmente robots de motores de búsqueda) sobre cómo rastrear las páginas en su sitio web. El archivo robots.txt es parte del protocolo de exclusión de robots (REP), un grupo de estándares web que regulan cómo los robots rastrean la web, acceden e indexan contenido y sirven ese contenido a los usuarios. El REP también incluye directivas como meta robots, así como instrucciones de página, subdirectorio o en todo el sitio sobre cómo los motores de búsqueda deben tratar los enlaces (como “follow” o “nofollow”).

En la práctica, los archivos robots.txt indican si ciertos user-agent (software de rastreo web) pueden o no rastrear partes de un sitio web. Estas instrucciones de rastreo se especifican al “no permitir” o “permitir” el comportamiento de ciertos (o todos) agentes de usuario.

Una forma básica del contenido en un archivo Robots.txt puede ser la siguiente:

User-agent: Googlebot Disallow: /nogooglebot/

No te preocupes si ahora no logras comprender que significa, mas adelante explicaremos estos parámetros.

Juntas, estas dos líneas se consideran un archivo robots.txt completo, aunque un archivo de robots puede contener varias líneas de agentes de usuario y directivas (es decir, disallows, allows, crawl-delays, etc).

Dentro de un archivo robots.txt, cada conjunto de directivas de user-agent aparece como un conjunto discreto, separado por un salto de línea:

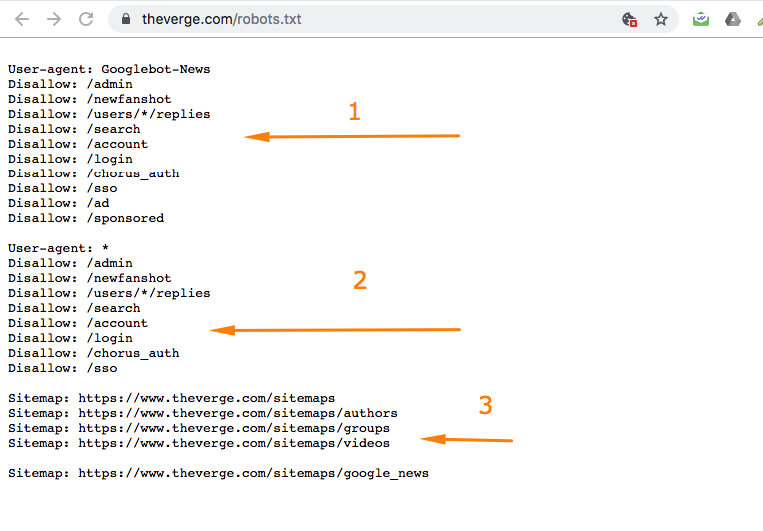

En un archivo robots.txt con múltiples directivas de agente de usuario, cada regla de rechazo o permiso solo se aplica a los agentes de uso especificados en ese conjunto separado por un salto de línea en particular. Si el archivo contiene una regla que se aplica a más de un user-agent, un rastreador solo prestará atención (y seguirá las instrucciones) al grupo de instrucciones más específico.

Por ejemplo:

Msnbot, discobot y Slurp se mencionan específicamente, por lo que esos user-agent solo prestarán atención a las directivas en sus secciones del archivo robots.txt. Todos los demás user-agent seguirán las directivas en el grupo de user-agent: *.

Ejemplos de algunos robots.txt

Aquí hay algunos ejemplos de robots.txt en acción usados en un sitio web de ejemplo www.example.com:

URL del archivo Robots.txt: www.example.com/robots.txt

Bloquear todos los rastreadores web de todo el contenido

User-agent: * Disallow: /

El uso de esta sintaxis en un archivo robots.txt indicaría a todos los rastreadores web que no rastreen ninguna página en www.example.com, incluida la página de inicio, muy conveniente cuando estamos en labores de desarrollo.

Permitir a todos los rastreadores web acceder a todo el contenido

User-agent: * Disallow:

El uso de esta sintaxis en un archivo robots.txt le dice a los rastreadores web que rastreen todas las páginas en www.example.com, incluida la página de inicio.

Bloquear un rastreador web específico desde una carpeta específica

User-agent: Googlebot Disallow: /example-subfolder/

Esta sintaxis solo le dice al rastreador de Google (nombre de agent-user Googlebot) que no rastree ninguna página que contenga la cadena URL www.example.com/example-subfolder/.

Bloquear un rastreador web específico desde una página web específica

User-agent: Bingbot Disallow: /example-subfolder/blocked-page.html

Esta sintaxis solo le dice al rastreador de Bing (nombre de user-agent Bing) que evite rastrear la página específica en www.example.com/example-subfolder/blocked-page.html

¿Cómo funciona el archivo robots.txt?

Los motores de búsqueda tienen dos funciones principales:

- Rastrear la web para descubrir contenido;

- Indexación de ese contenido para que pueda ser entregado a los buscadores que buscan información.

Para rastrear sitios, los motores de búsqueda siguen enlaces para ir de un sitio a otro y, en última instancia, rastrean miles de millones de enlaces y sitios web. Este comportamiento de rastreo a veces se conoce como “araña”.

Después de llegar a un sitio web pero antes de explorarlo, el rastreador de búsqueda buscará un archivo robots.txt. Si encuentra uno, el rastreador leerá ese archivo primero antes de continuar por la página. Debido a que el archivo robots.txt contiene información sobre cómo debe rastrearse el motor de búsqueda, la información que se encuentra allí le indicará una acción adicional del rastreador en este sitio en particular. Si el archivo robots.txt no contiene ninguna directiva que no permita la actividad de un agente de usuario (o si el sitio no tiene un archivo robots.txt), procederá a rastrear otra información en el sitio.

La Sintaxis técnica de robots.txt

La sintaxis de Robots.txt puede considerarse como el “idioma” de los archivos robots.txt. Hay cinco términos comunes que probablemente encuentres en un archivo de robots. Incluyen:

- User-agent: El rastreador web específico al que le está dando instrucciones de rastreo (generalmente un motor de búsqueda). Puede encontrar una lista de la mayoría de los user-agent aquí.

- Disallow: El comando utilizado para indicarle a un agente de usuario que no rastree una URL en particular. Solo se permite una línea “Disallow:” para cada URL.

- Allow: (solo aplicable para el robot de Google): el comando para indicarle al robot de Google que puede acceder a una página o subcarpeta aunque su página principal o subcarpeta no esté permitida.

- Crawl-delay: Cuántos segundos debe esperar un rastreador antes de cargar y rastrear el contenido de la página. Tenga en cuenta que Googlebot no reconoce este comando, pero la frecuencia de rastreo se puede establecer en Google Search Console.

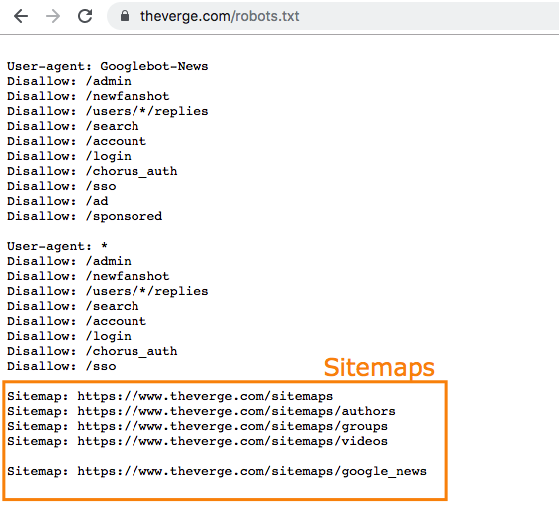

- Sitemap: se utiliza para indicar la ubicación de cualquier mapa del sitio XML asociado con esta URL. Tenga en cuenta que este comando solo es compatible con Google, Ask, Bing y Yahoo.

La coincidencia de patrones

Cuando se trata de bloquear o permitir las URL reales, los archivos robots.txt pueden volverse bastante complejos ya que permiten el uso de la coincidencia de patrones para cubrir un rango de posibles opciones de URL. Google y Bing honran dos expresiones regulares que pueden usarse para identificar páginas o subcarpetas que un SEO quiere excluir. Estos dos caracteres son el asterisco (*) y el signo de dólar o peso ($).

- * es un comodín que representa cualquier secuencia de caracteres.

- $ coincide con el final de la URL.

Google ofrece una gran lista de posibles sintaxis de coincidencia de patrones y ejemplos aquí.

¿Cual es la ubicación del archivo robots.txt en una página web?

Cada vez que visitan un sitio, los motores de búsqueda y otros robots de rastreo web (como el rastreador de Facebook , Facebot) saben buscar un archivo robots.txt. Pero, solo buscarán ese archivo en un lugar específico: el directorio principal (generalmente su dominio raíz o página de inicio). Si un user-agent visita www.example.com/robots.txt y no encuentra un archivo de robots allí, asumirá que el sitio no tiene uno y procederá a rastrear todo en la página (y tal vez incluso en todo el sitio). Incluso si la página tiene el archivo en otro dicterio como, example.com/index/robots.txt o www.example.com/homepage/robots.txt, no sería descubierto por los agentes de usuario y por lo tanto el sitio sería tratado como si no tuviera ningún archivo de robots.

Para asegurarse de encontrar su archivo robots.txt, inclúyalo siempre en su directorio principal o dominio raíz.

¿Por qué necesitas robots.txt?

Los archivos Robots.txt controlan el acceso del rastreador a ciertas áreas de su sitio. Si bien esto puede ser muy peligroso si accidentalmente no permite que Googlebot rastree todo su sitio, hay algunas situaciones en las que un archivo robots.txt puede ser muy útil.

Algunos casos de uso comunes incluyen:

- Evitar que el contenido duplicado aparezca en SERPs (tenga en cuenta que los meta robots suelen ser una mejor opción para esto).

- Mantener privadas secciones enteras de un sitio web (por ejemplo, el sitio de preparación de su equipo de ingeniería).

- Evitar que las páginas de resultados de búsqueda interna aparezcan en un SERP público

- Especificar la ubicación de los mapas del sitio.

- Evitar que los motores de búsqueda indexen ciertos archivos en su sitio web (imágenes, PDF, etc.).

- Especificar un retraso de rastreo para evitar que sus servidores se sobrecarguen cuando los rastreadores cargan múltiples piezas de contenido a la vez.

Si no hay áreas en su sitio en las que desee controlar el acceso de agente de usuario, es posible que no necesite un archivo robots.txt.

Cómo crear un archivo robots.txt

Si descubrió que no tenía un archivo robots.txt o desea modificar el suyo, crear uno es un proceso simple. Este artículo de Google explica el proceso de creación del archivo robots.txt, y esta herramienta le permite probar si su archivo está configurado correctamente.

Comprobando si tiene un archivo robots.txt

¿No está seguro si tiene un archivo robots.txt? Simplemente escriba su dominio raíz, luego agregue /robots.txt al final de la URL. Por ejemplo, el archivo de robots de Andres dev se encuentra en andres-dev.com/robots.txt.

Si no aparece una página .txt, actualmente no tiene creado el archivo correcto y puedes volver al tema de creación para crearlo.

Mejores prácticas de SEO

- Asegúrese de no estar bloqueando el contenido o las secciones de su sitio web que desea rastrear.

- No se seguirán los enlaces en páginas bloqueadas por robots.txt. Esto significa 1.) A menos que también estén vinculados desde otras páginas accesibles para motores de búsqueda (es decir, páginas no bloqueadas a través de robots.txt, meta robots u otros), los recursos vinculados no se rastrearán ni podrán indexarse. 2.) No se puede transferir la equidad del enlace desde la página bloqueada al destino del enlace. Si tiene páginas a las que desea que se transfiera el capital, use un mecanismo de bloqueo diferente que no sea robots.txt.

- No utilice el archivo robots.txt para evitar que los datos confidenciales (como la información privada del usuario) aparezcan en los resultados de SERP. Debido a que otras páginas pueden vincular directamente a la página que contiene información privada (sin pasar por las directivas de robots.txt en su dominio raíz o página de inicio), aún puede indexarse. Si desea bloquear su página de los resultados de búsqueda, use un método diferente como la protección con contraseña o la meta directiva noindex .

- Algunos motores de búsqueda tienen múltiples user-agent. Por ejemplo, Google usa Googlebot para búsqueda orgánica y Googlebot-Image para búsqueda de imágenes. La mayoría de los user-agent del mismo motor de búsqueda siguen las mismas reglas, por lo que no es necesario especificar directivas para cada uno de los múltiples rastreadores de un motor de búsqueda, pero tener la capacidad de hacerlo le permite ajustar cómo se rastrea el contenido de su sitio.

- Un motor de búsqueda almacenará en caché el contenido de robots.txt, pero generalmente actualiza el contenido en caché al menos una vez al día. Si cambia el archivo y desea actualizarlo más rápido de lo que está ocurriendo, puede enviar su URL de robots.txt a Google Search Console.

Otras recomendaciones para el robots.txt

- Para poder encontrarlo, se debe colocar un archivo robots.txt en el directorio de nivel superior de un sitio web.

- Robots.txt distingue entre mayúsculas y minúsculas: el archivo debe llamarse “robots.txt” (no Robots.txt, robots.TXT u otro).

- Algunos agentes de usuario (robots) pueden optar por ignorar su archivo robots.txt. Esto es especialmente común con rastreadores más nefastos como robots de malware o raspadores de direcciones de correo electrónico.

- El archivo /robots.txt está disponible públicamente: simplemente agregue /robots.txt al final de cualquier dominio raíz para ver las directivas de ese sitio web (¡si ese sitio tiene un archivo robots.txt!). Esto significa que cualquiera puede ver qué páginas hace o no desea rastrear, así que no las use para ocultar información privada del usuario.

- Cada subdominio en un dominio raíz usa archivos robots.txt separados. Esto significa que tanto blog.example.com como example.com deben tener sus propios archivos robots.txt (en blog.example.com/robots.txt y example.com/robots.txt).

- En general, se recomienda indicar la ubicación de los mapas de sitio asociados con este dominio en la parte inferior del archivo robots.txt. Aquí hay un ejemplo:

![[Guía Completa] Todo sobre el archivo Robots.txt [Guía Completa] Todo sobre el archivo Robots.txt](https://andres-dev.com/wp-content/uploads/2019/11/Guia-basica-Robots-24x10.jpg)